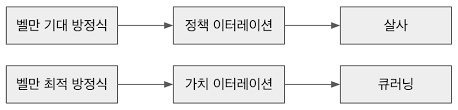

개요 앞에서 배운 DQN 알고리즘은 그때그때의 샘플들로 학습했을 때, 샘플끼리의 연관성으로 에이전트가 잘못 학습하는 문제를 해결하기 위해서 경험 리플레이를 사용했습니다. 샘플을 리플레이 메모리에 많이 모은 후에 임의 추출한 샘플을 사용해 성공적인 학습을 이끌어냈죠. 하지만 리플레이 메모리가 커서 컴퓨터의 많은 메모리를 차지한다면 학습의 속도는 느려지며, 과거의 정책을 사용하기 때문에 오프폴리시 강화학습(DQN의 경우 큐러닝)만을 사용해야 한다는 단점이 있습니다. 이러한 단점 때문에 다른 방법으로 문제에 접근해 만들어진 것이 A3C(Asynchronous Advantage Actor-Critic) 알고리즘입니다. A3C란 무엇일까? DQN 알고리즘이 리플레이 메모리를 사용해 샘플 사이의 연관성을 깼다면, ..