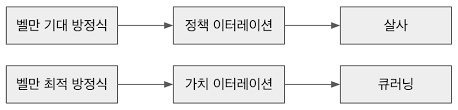

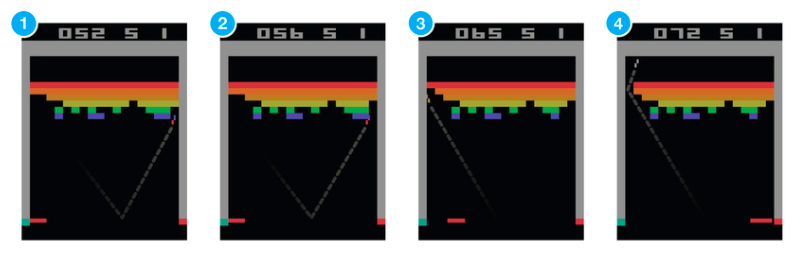

개요 이전 포스팅에서는 첫 번째 강화학습 알고리즘인 살사에 대해서 배웠습니다. 살사는 ε-탐욕 정책으로 행동하면서 샘플 [St,At,Rt+1,St+1,At+1]을 모으고 이 샘플을 이용해서 시간차 제어 식으로 큐함수를 업데이트하는 과정을 반복하였습니다. Q(S_t,A_t) \leftarrow Q(S_t,A_t) + α(R_{t+1} + γQ(S_{t+1},A_{t+1})) - Q(S_t,A_t)) 하지만 이런 살사를 이용해서 에이전트를 학습시키다보면 잘못된 정책을 학습하는 경우가 생깁니다. 이번 포스팅에서는 살사의 한계와 이를 극복하기 위해 만들어진 2번째 강화학습 알고리즘, 큐러닝을 예시 코드와 함께 살펴보겠습니다. 살사의 한계 살사는 충분한 탐험을 하기 위해서 ε-탐욕 ..